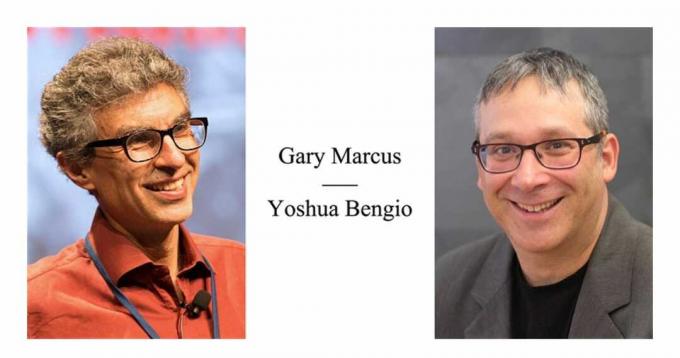

Yoshua Bengio og Gary Marcus holdt en debat i Montreal i mandags om fremtiden for kunstig intelligens. Derefter holdt de endnu en debat på Medium og Facebook om, hvad begrebet "deep learning" betyder.

Mandagens historiske debat mellem maskinlæringsbelyste Yoshua Bengio og maskinlæringskritiker Gary Marcus væltede over til en tit for tat mellem de to i dagene efter, mest om status for udtrykket "dyb læring."

Historien om begrebet dyb læring viser, at brugen af det til tider har været opportunistisk, men har haft meget lidt at gøre i vejen for at fremme videnskaben om kunstig intelligens. Derfor vil den nuværende debat sandsynligvis ikke gå nogen steder i sidste ende.

Mandag aftens debat fandt, at Bengio og Marcus talte om lignende tilsyneladende slutmål, ting som behovet for "hybride" intelligensmodeller, måske ved at kombinere neurale netværk med noget i retning af en "symbol" klasse af objekt. Detaljerne var, hvor de to skændtes om definitioner og terminologi.

I dagene efter, Marcus,

i et opslag på Medium, observerede, at Bengio så ud til at have hvidvasket sin egen nylige kritik af mangler i dyb læring. Og Bengio svarede: i et brev på Google Docs linket fra hans Facebook-konto, at Marcus formodede at fortælle deep learning-fællesskabet, hvordan det kan definere sine vilkår. Marcus svarede i et opfølgende indlæg ved at foreslå, at de skiftende beskrivelser af dyb læring er "sjusket". Bengio svarede igen sent fredag på sin Facebook-side med en definition af dyb læring som et mål, der siger: "Dyb læring er inspireret af neurale netværk i hjernen til at bygge læringsmaskiner, der opdager rige og nyttige interne repræsentationer, beregnet som en sammensætning af indlærte funktioner og funktioner." Bengio bemærkede, at definitionen ikke dækkede "hvordan" af sagen, og efterlod den åben.Bengios MILA-institut, hvor mandagens debat fandt sted, holder et løbende arkiv af links af de forskellige rater af begge personer.

Også: Djævelen er i detaljerne i historisk AI-debat

Udtrykket "deep learning" er dukket op adskillige gange gennem årtier, og det er blevet brugt på forskellige måder. Det har aldrig været strengt, og uden tvivl vil det ændre sig igen, og på et tidspunkt kan det miste sin nytteværdi.

Jürgen Schmidhuber, der var medudviklede "lang-korttidshukommelsen"-formen for neurale netværk, har skrevet at AI-forskeren Rina Dechter første gang brugte udtrykket "deep learning" i 1980'erne. Den brug var anderledes end nutidens brug. Dechter skrev om metoder til at søge i en graf over et problem, uden at have meget at gøre med dybe netværk af kunstige neuroner. Men der var en lighed: hun brugte ordet "dyb" som en måde at indikere graden af kompleksitet af et problem og dets løsning, hvilket er, hvad andre begyndte at gøre i det nye århundrede.

Den samme form for heuristisk brug af dyb læring begyndte at ske med Bengio og andre omkring 2006, da Geoffrey Hinton tilbød banebrydende arbejde på neurale netværk med mange flere lag af beregninger end tidligere. Fra det år begyndte Hinton og andre i feltet at henvise til "dybe netværk" i modsætning til tidligere arbejde, der brugte samlinger af kun et lille antal kunstige neuroner.

Fra Yoshua Bengios slides til AI-debatten med Gary Marcus, 23. december.

Så dyb læring dukkede op som en meget grov, meget bred måde at skelne mellem en lagdelt tilgang, der får ting som AlexNet til at fungere.

I mellemtiden, som Marcus foreslår, har begrebet deep learning været så vellykket i den populære litteratur, at det har fået et branding-aspekt, og det er blevet en slags catchall, som nogle gange kan virke, som om det står for hvad som helst. Marcus' bedste arbejde har været at påpege, hvor kavalerligt og uansvarligt sådanne udtryk bruges (for det meste af journalister og virksomheder), hvilket forårsager forvirring blandt offentligheden. Virksomheder med "dybt" i deres navn har helt sikkert mærket deres præstationer og tjent flere hundrede millioner for det. Så emnet branding er på en eller anden måde uundgåeligt.

Bengios svar antyder, at han ikke bekymrer sig meget om den semantiske drift, som udtrykket har gennemgået, fordi han har fokuseret på at praktisere videnskab, ikke på at definere termer. For ham er dyb læring nyttig som pladsholder for et fællesskab af tilgange og praksisser, der udvikler sig sammen over tid.

Også: Intels neuro-guru kritiserer dyb læring: 'det lærer faktisk ikke'

Sandsynligvis vil deep learning som begreb på et tidspunkt forsvinde fra scenen, ligesom det og andre begreber er svævet ind og ud af brug over tid.

Der var faktisk noget andet i mandagens debat, der var langt mere provokerende end branding-spørgsmålet, og det var Bengios insistere på, at alt i deep learning er forenet i en eller anden henseende via begrebet optimering, typisk optimering af et mål fungere. Det kunne være en tabsfunktion eller en energifunktion eller noget andet, afhængigt af konteksten.

Faktisk har Bengio og kolleger argumenteret i en nylig avis at forestillingen om objektive funktioner bør udvides til neurovidenskab. Som de udtrykte det: "Hvis tingene ikke 'bliver bedre' ifølge en eller anden metrik, hvordan kan vi så henvise til enhver fænotypisk plasticitet som 'læring' i modsætning til blot 'ændringer'?"

Det er så grundlæggende en idé, det virker så indlysende, at det næsten virker trivielt for Bengio at insistere på det.

Men det er ikke trivielt. At insistere på, at et system optimerer langs en eller anden vektor, er en holdning, som ikke alle er enige i. For eksempel Mike Davies, leder af Intels "neuromorfe" chipindsats, sidste februar kritiserede tilbage-udbredelse, den vigtigste læringsregel, der bruges til at optimere i dyb læring, under en tale på International Solid State Circuits Conference.

Davies' klage er, at back-prop er i modsætning til menneskelig hjerneaktivitet, idet han hævder "det er virkelig en optimeringsprocedure, det er faktisk ikke læring."

Deep learnings tilhængere har således mindst én hovedprincip, der er meget bred, men heller ikke uden kontroverser.

Moralen i historien er, at der altid vil være noget at skændes om.