Unterdessen gab HPE bekannt, dass es mit dem US-Energieministerium bei der Erforschung von KI-Operationen zusammenarbeitet

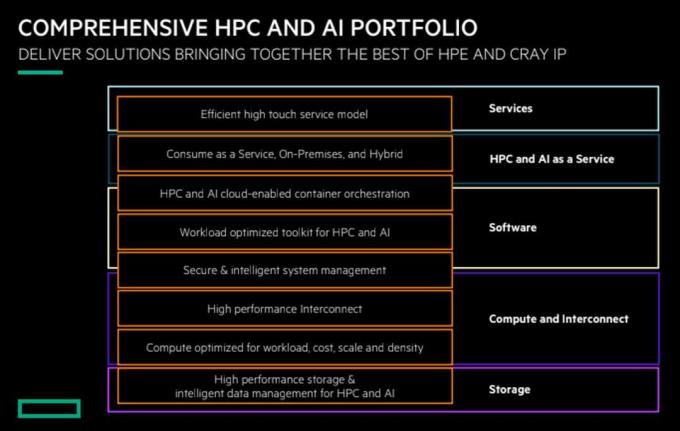

Sechs Monate später Übernahme von Cray im Wert von 1,3 Milliarden US-Dollar Für seine High-Performance-Computing-Technologie (HPC) stellt HPE ein neu überarbeitetes Portfolio vor, das HPE- und Cray-Technologie kombiniert, um HPC-, KI- und Analyse-Workloads zu unterstützen. Laut HPE besteht die Absicht darin, den Kunden ein End-to-End-Portfolio aus Services, Software, Rechenleistung, Verbindungs- und Speicherfunktionen für HPC- und KI-Workloads – bereitgestellt vor Ort oder als Service.

Cray ist einer der führenden Anbieter im Supercomputing und seine Technologien sollen HPE dabei helfen, Exascale-Lösungen für eine Reihe von Branchen und Anwendungen zu entwickeln. einschließlich Modellierung und Simulation in der Wettervorhersage, im verarbeitenden Gewerbe und im Energiesektor, in der Präzisionsmedizin, bei autonomen Fahrzeugen, in der Geoinformatik und im Finanzwesen Dienstleistungen.

- SEHEN: HPE kauft den Supercomputer-Hersteller Cray für 1,3 Milliarden US-Dollar ¦ Cray erhält vom DOE einen 600-Millionen-Dollar-Auftrag zum Bau des Exascale-Supercomputers El Capitan ¦ HPE plant, „All-in-as-a-Service“ mit einer großen Portion Greenlake anzubieten

„Durch die Kombination der HPE- und Cray-Angebote geben wir unseren Kunden nun mehr Auswahl und Kontrolle bei der Anwendung von HPC, und zwar flächendeckend.“ Größe und Skalierung, die in jeder Umgebung ausgeführt werden können, von lokal bis zur Cloud“, sagte Peter Ungaro, SVP und GM von HPE und AI für HPE, in einem Stellungnahme.

- Was die Rechenleistung angeht, erweitert HPE sein Portfolio um Cray-Supercomputer, um die HPE-Familie der Apollo-Systeme zu ergänzen. Kunden können jetzt von Einzelserverlösungen bis hin zu den größten Supercomputern von Cray wählen. Die neuen Cray-Systeme werden auf der Shasta-Architektur basieren, mit der zunächst geliefert wird drei US-Exascale-Systeme.

- Die Software von HPE für die Verwaltung von HPC- und KI-Systemen umfasst die Shasta System Software von Cray, die die gleichzeitige Ausführung konvergierter HPC- und KI-Workloads auf einem einzigen System ermöglicht. Es enthält auch die Cray Programming Environment (CPE), eine vollständig integrierte Software-Suite mit Compiler, Tools und Bibliotheken für die Anwendungsentwicklung und -verwaltung in komplexen HPC- und KI-Umgebungen Arbeitsbelastungen.

- Um den Anforderungen nach höherer Geschwindigkeit und geringerer Datenlatenz gerecht zu werden, bietet HPE Cray Slingshot an, eine neu definierte HPC-Verbindung. Slingshot beginnt mit einem Durchsatz von 200 Gbit/s und bietet einzigartige Überlastungskontrollkabel für die gleichzeitige Abwicklung mehrerer datenintensiver Arbeitsabläufe auf einem einzigen System.

- Für Hochleistungsspeicher bietet HPE den kürzlich eingeführten Cray ClusterStor E1000 an. ClusterStor nutzt intelligente Datenverwaltungssoftware, um den Bedarf an zusätzlichen Speicherlaufwerken zu reduzieren. Mittlerweile lässt sich die High Performance Cluster Management (HPCM)-Software von HPE auf 100.000 Knoten skalieren.

- Das Portfolio umfasst technische und Beratungsdienste von HPE PointNext, um Kunden bei der Konzeption und Beschleunigung von Bereitstellungen zu unterstützen. HPE erweitert diese Angebote durch die Services von Cray, darunter Support für Installation, Fehlerbehebung, Systemwartung, Systemadministration und Systemoptimierung.

- Schließlich arbeiten Cray und Microsoft, wie bereits angekündigt, zusammen, um den Zugriff auf HPC-Technologie und -Systeme für Cray in Microsoft Azure-Angeboten zu ermöglichen. HPE plant auch, seine HPC- und KI-Lösungen über anzubieten HPE GreenLake, sein As-a-Service-Angebot.

Unterdessen kündigte HPE am Montag auch eine Zusammenarbeit mit dem National Renewable Energy Laboratory (NREL) des US-Energieministeriums zur Erforschung und Entwicklung neuer KI-Ops-Technologien an. Ziel ist es, die betriebliche Effizienz von Rechenzentren im Exascale-Zeitalter zu automatisieren und zu verbessern, insbesondere im Hinblick auf Ausfallsicherheit und Energieverbrauch.

Laut Bundesforschung wird der Wasser- und Energieverbrauch in US-Rechenzentren bis 2020 voraussichtlich etwa 73 Milliarden kWh und 174 Milliarden Gallonen Wasser erreichen.

HPE und NREL verwenden historische Daten aus mehr als fünf Jahren – mehr als 16 Terabyte an Daten –, die von Sensoren in den Supercomputern von NREL gesammelt wurden, um Modelle für die Anomalieerkennung zu trainieren. Dies sollte es den Modellen ermöglichen, Probleme vorherzusagen und zu verhindern, bevor sie auftreten.

Das AI Ops-Projekt entstand aus den Forschungs- und Entwicklungsbemühungen von HPE mit Path Forward, einem vom DOE unterstützten Programm zur Beschleunigung der Exascale-Computing-Roadmap des Landes.