Nvidia ha annunciato un programma software desktop chiamato AI Workbench per containerizzare più facilmente i modelli di rete neurale sulle workstation locali per metterli in scena per il cloud.

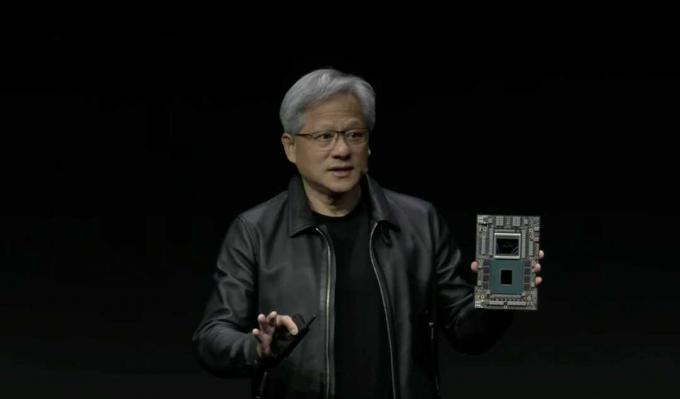

Il CEO di Nvidia Jensen Huang martedì ha mostrato la prossima iterazione della sua azienda della combinazione CPU e GPU, il "GH200" Grace Hopper "superchip". La parte aumenta la capacità di memoria a 5 terabyte al secondo per gestire le dimensioni crescenti dell'intelligenza artificiale Modelli.

Nvidia prevede di lanciare il prossimo anno una versione migliorata di quello che chiama "superchip" che combina CPU e GPU, con una memoria più veloce, per spostare più dati dentro e fuori i circuiti del chip. Il CEO di Nvidia Jensen Huang ha realizzato il annuncio Martedì durante il suo discorso alla fiera di computer grafica SIGGRAPH a Los Angeles.

Il chip GH200 è la versione successiva del chip combinato Grace Hopper, annunciato all'inizio di quest'anno, che è già disponibile nella sua versione iniziale nei computer Dell e altri.

Anche: Nvidia svela il nuovo tipo di Ethernet per l'intelligenza artificiale, il "Superchip" di Grace Hopper in piena produzione

Mentre il Grace Hopper iniziale contiene 96 gigabyte di memoria HBM per alimentare la GPU Hopper, la nuova versione contiene 140 gigabyte di HBM3e, la versione successiva dello standard di memoria a larghezza di banda elevata. HBM3e aumenta la velocità dei dati che alimenta la GPU a 5 terabyte (trilioni di byte) al secondo dai 4 terabyte del Grace Hopper originale.

La GH200 seguirà di un anno l'originale Grace Hopper, che Huang detto a maggio era in piena produzione.

"I chip sono in produzione, li proveremo alla fine dell'anno, o giù di lì, e saremo in produzione entro la fine del secondo trimestre [2024]", ha detto martedì.

Il GH200, come l'originale, presenta 72 core CPU basati su ARM nel chip Grace e 144 core GPU nella GPU Hopper. I due chip sono collegati attraverso il circuito da un'interfaccia di memoria ad alta velocità e coerente con la cache, NVLink, che consente alla GPU Hopper di accedere alla memoria DRAM della CPU

Huang ha descritto come il GH200 possa essere collegato a un secondo GH200 in un server a doppia configurazione, per un totale di 10 terabyte di larghezza di banda della memoria HBM3e.

GH200 è la versione successiva del superchip Grace Hopper, progettato per condividere il lavoro dei programmi di intelligenza artificiale tramite uno stretto accoppiamento di CPU e GPU.

L'aggiornamento della velocità della memoria delle parti della GPU è abbastanza standard per Nvidia. Ad esempio, la generazione precedente di GPU - A100 "Ampere" - è passata da HBM2 a HBM2e.

HBM ha iniziato a sostituire il precedente standard di memoria GPU, GDDR, nel 2015, spinta dalle maggiori richieste di memoria dei display 4K per la grafica dei videogiochi. HBM è una configurazione di memoria "impilata", con i singoli die di memoria impilati verticalmente uno sopra l'altro e collegati a tra loro tramite un "via di silicio passante" che attraversa ciascun chip fino a un "micro-bump" saldato sulla superficie tra ciascuno patata fritta.

Programmi di intelligenza artificiale, in particolare il IA generativa tipo come ChatGPT, richiedono molta memoria. Devono memorizzare un numero enorme di pesi neurali, o parametri, le matrici che sono le principali unità funzionali di una rete neurale. Questi pesi aumentano con ogni nuova versione di un programma di intelligenza artificiale generativa come un modello linguistico di grandi dimensioni, e tendono a raggiungere un trilione di parametri.

Anche: Nvidia supera i benchmark dell'intelligenza artificiale, ma Intel porta una concorrenza significativa

Sempre durante lo spettacolo, Nvidia ha annunciato numerosi altri prodotti e partnership.

Banco di lavoro AI è un programma in esecuzione su una workstation locale che semplifica il caricamento di modelli di rete neurale per il cloud in modo containerizzato. AI Workbench lo è utenti attualmente iscritti per l'accesso anticipato.

Nuovo configurazioni della postazione di lavoro per l'intelligenza artificiale generativa, di Dell, HP, Lenovo e altri, sotto il marchio "RTX", combineranno fino a quattro "GPU RTX 6000 Ada" dell'azienda, ciascuna delle quali ha 48 gigabyte di memoria. Ogni workstation desktop può fornire fino a 5.828 trilioni di operazioni in virgola mobile al secondo (TFLOP) di prestazioni AI e 192 gigabyte di memoria GPU, ha affermato Nvidia.

Puoi guardare il replay dell'intero keynote di Huang su il sito web di Nvidia.

Intelligenza artificiale

- 7 suggerimenti avanzati per la scrittura di messaggi ChatGPT che devi conoscere

- I 10 migliori plugin ChatGPT del 2023 (e come sfruttarli al meglio)

- Ho testato molti strumenti di intelligenza artificiale per il lavoro. Questi sono i miei 5 preferiti finora

- Umano o bot? Questo gioco di test di Turing mette alla prova le tue abilità di individuazione dell'intelligenza artificiale